モーションキャプチャで記録したダンスの動きと、かかっている音楽の特徴量の関係を学習することで、音楽の特徴にぴったりくるような自然なダンスの動きを自動生成しようという研究。

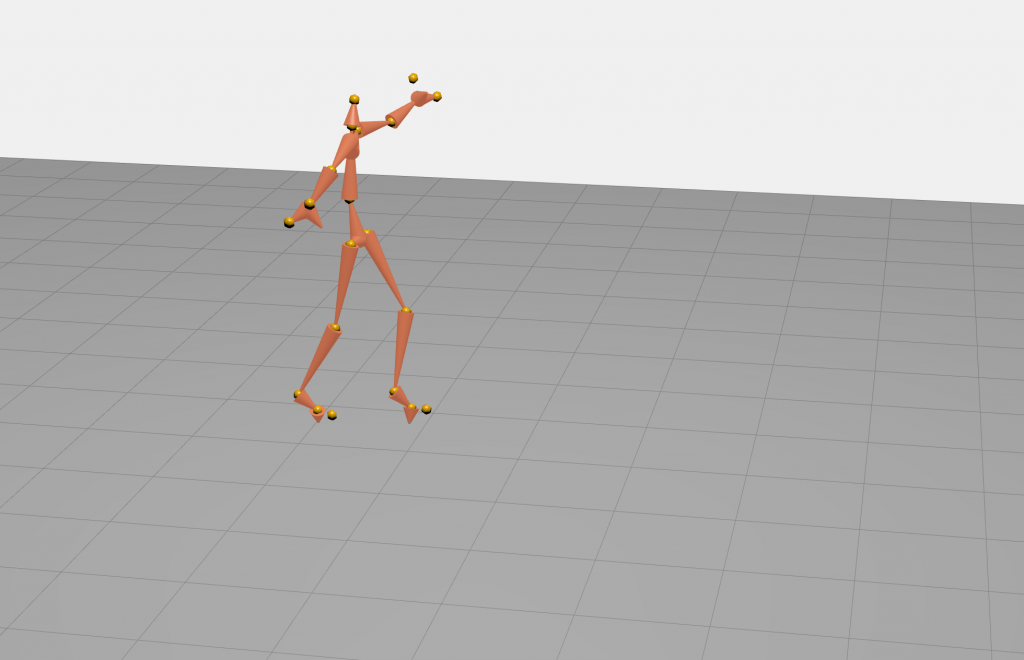

学習に用いるデータは、次のようなモーションキャプチャで得られた関節の動きの時系列データです。 あわせて学習にもちいる音楽の特徴は、音の大きさ (RMS)や

低域、中域、高域、それぞれのエネルギーやメルケプストラムなど、音楽情報処理で一般的に用いられている特徴量になります。

学習したモデルで生成した動きは次のビデオのようなものです。論文の中で著者が認めているように、まだまだうまくいっていない部分も多いのですが、楽曲の音響的な特徴量からリズムにあった動き(ダンスといえるかどうかは微妙ですが)が生成されているのだけでもは十分面白いですね。

We present the preliminary results of GrooveNet, a generative system

that learns to synthesize dance movements for a given audio

track in real-time. Our intended application for GrooveNet is a public

interactive installation in which the audience can provide their

own music to interact with an avatar. We investigate training artificial

neural networks, in particular, Factored Conditional Restricted

Boltzmann Machines (FCRBM) and Recurrent Neural Networks

(RNN), on a small dataset of four synchronized music and motion

capture recordings of dance movements that we have captured for

this project. Our initial results show that we can train the FCRBM

on this small dataset to generate dance movements. However, the

model cannot generalize well to music tracks beyond the training

data. We outline our plans to further develop GrooveNet.