LINK

一般的な畳み込みニューラルネットワーク(CNN)を使って、抽象的な絵を描くプロジェクト。 ニュージーランドのアーティスト、研究者 Tom White氏によるプロジェクトです。

このプロジェクトの面白いところは、DeepDreamやStyle Transferのようにニューラルネットによって画像を直接生成するのではなく、線や円で構成されるシンプルな絵を描くシステムを用意している点。

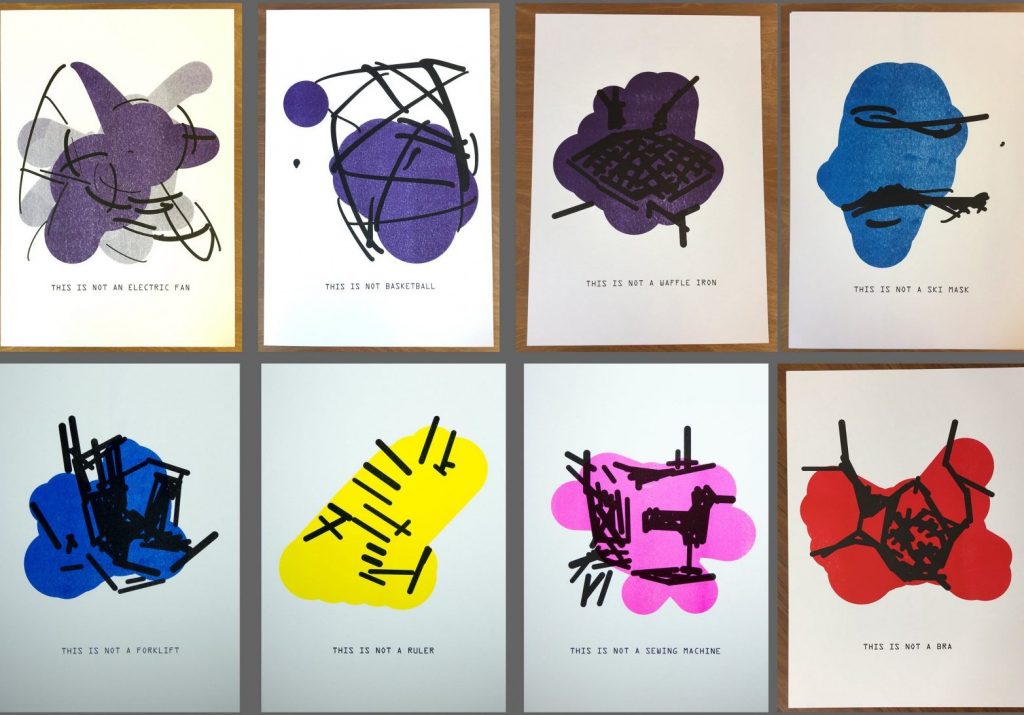

そして用意したCNNの特定のクラスとして識別される割合をなるべく高くするというのが、このお絵かきシステムの目的になります。下の例ではImageNetで学習したCNNを用いていて、クラスとしては「扇風機」が選ばれています。ランダムに円や線を足し引きすることを繰り返すことで、より「扇風機らしい」絵が生成されていきます (特に勾配の情報は使われてはいないので、単純なrandom searchと言えますね) 。

実際に紙にプリントした時にも「それらしく見える」ことを担保するために、あえて生成された絵を回転させたり、明度/ホワイトバランスを変えても、選択されたラベルとして高い割合で識別されるかどうかもシミュレーションしているそうです。最終的にプリントしたものを写真に撮って、それが正しく選択したラベル(扇風機)として識別されるかどうかというevaluationまで行なっているのも面白いですね。

こうして描かれた絵の例が次の写真です。人間の目から見ても、選択されたImageNetのラベルの特徴をそれぞれ備えているように感じるのですがいかがでしょうか。ImageNetのどのクラスに対応しているのか、想像しながら見てみると良いと思います。この辺は Adversarial Examples(敵対的事例 – 小さな変化を画像に与えることで識別器を「だます」)の考え方とも通じるものがありますね。

絵をコンピュータを使って描こうとした時に、コンピュータはツールであり、最終的な評価をするのは人間のアーティスト… という枠組みが一般的なのに対して、この作品では評価をするのもコンピュータです。アーティストは全体のフレームワークを作るというかたちで作品に貢献しています。アーティストとAIの関係という観点からも非常に興味深いプロジェクトです。

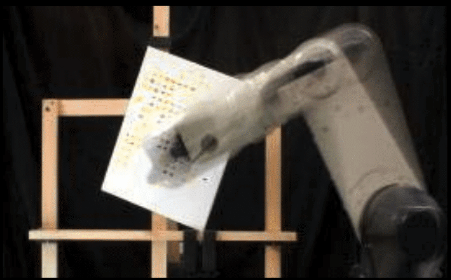

似たような例としては、2008年にAguilarとLipsonが発表したロボットアームで絵を書く作品があります。この作品ではブラシの動かし方のパターンを遺伝的アルゴリズムで最適化しています。

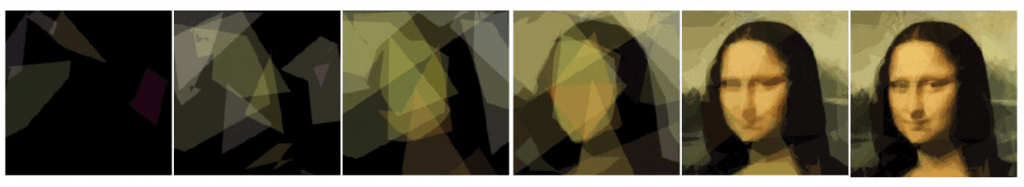

同様に2008年のAlsinの作品では、50個の半透明の四角を画面上に配置するやり方を遺伝的アルゴリズムで最適化することでさまざまな絵を描くことに成功しています。

この二つのプロジェクトでは、ともに 元の写真とできあがった絵を単純にピクセル単位で比較し、なるべく差が小さいものが高く評価されるという手法を取っています。当時は描かれた絵との単純な比較でしかなかったのに対して、今回紹介したプロジェクトでは、CNNを用いることで、「〇〇っぽさ」を評価できるようになってきているという点も注目に値します。

Meidum(2018.04.05公開)

A visual overview examining the ability of neural networks to create abstract representations from collections of real world objects. An architecture called perception engines is introduced that is able to construct representational physical objects and is powered primarily by computational perception. An initial implementation was used to create several ink prints based on ImageNet categories, and permutations of this technique are the basis of ongoing work.